COPU会议纪要丨2026.01.27

1月27日,陆主席主持召开COPU例会。

一、 本次会议首先讨论豆包、混元、MiniMax、文心、GLM五个大模型崛起的问题。

字节豆包、腾讯混元、MiniMax、百度文心、智谱AI的崛起

COPU 2016.1.20

以往我们一直在连续介绍的、居于全球排行榜前列的国产大模型:如深度求索的DeepSeek系列、阿里通义千问的Qwen系列、月之暗面的Kimi系列,他们的产品都是开源的。

现在介绍最近崛起的部分大模型,如智谱AI、字节豆包、腾讯混元、百度文心、MiniMax的产品。1月20日,COPU听取百度张军关于文心V5.0的汇报,COPU陆主席问文心V5.0是开源的还是闭源的?张答是闭源的,但前一代是开源的。他笑着自嘲说,有人说我们是骑墙的。陆主席说,西方一些顶级的大模型,为了有利于其发展,采取开源和闭源的二元配置。张听到二元配置的提法后说声,谢谢!继续他的汇报。

2025年是中国大模型竞争的关键年份,各厂商在技术迭代、产业落地和生态建设上均取得显著进展,从技术能力上看,头部模型已接近国际一流水平。从商业化看,企业级应用成为主要收入来源,云端API和订阅服务快速增长;从生态上看,开源策略与行业合作成为差异化竞争焦点。

据2025年末至2026年初,各厂商官方发布的信息,这五大模型及平台的开源/闭源状态如下:

大致可分为:全面开源、部分开源、主体闭源(仅API服务或周边技术组件开源)。

“全面开源”指核心模型权重、训练代码、推理框架等完整技术栈开放开源(如MiniMax、智谱GLM);“部分开源”指仅部分规模或特定用途的模型开源,旗舰模型仍闭源(如腾讯混元、百度文心);“主体闭源”指核心商用模型不开放权重,仅通过API服务或开源周边技术组件(如字节豆包)。

字节豆包的Doubao系列模型为闭源商业模型,仅通过API提供服务。开源了部分技术组件(如COMET通信优化系统、video word视频生成模型)。腾讯混元部分开源混元系列存在开源和闭源双轨。Hunyuan-Large、-Video等部分模型已开源,但旗舰级模型(如混元2.0)仍为闭源商用服务。百度文心部分开源,文心4.5系列(47B、3B等规模)已开源,但旗舰文心5.0等最新版本仍为闭源商用,采用“基础版开源+专业版闭源”策略。智谱GLM系列(GLM-4.5、-4.6、-4.7)完全开源,权重、代码、推理框架全部开放。

各模型平台发展概况

1.字节豆包(Doubao)最新发布大模型1.8版本,在多模态理解、Agent能力和视频生成方面大幅升级,日均Token使用量突破50万亿,推出Seedance1.5pro音频创作模型,支持毫秒级音画同步,企业客户100家,累计Token使用量超1万亿。多模态agent能力突出,在Browser Comp等智能体测评中全球领先,C端流量优势明显,依托抖音、今日头条等超级APP,月活用户超1.5亿,支持256K上下文窗口。单次视频理解帧表达1280帧。在视觉推理、通用视觉问答等任务中,接近全球的顶尖模型。挑战:企业级服务深度仍需加强,技术底座对母公司依赖度较高。

2. 腾讯混元(Hunyuan)最新发布混元2.0模型,采用混合专家(MOE)架构,总参数406B,激活参数32B。混元图像3.0在文生图榜单排名第一,3D生成模型在多项任务中领先。生态协同优势:深度绑定微信、腾讯会议、企业微信等场景,覆盖超10亿用户潜在需求。在金融、教育等行业定制化服务的口碑良好,模型稳定性强。成本控制能力,API定价为输入0.8元/百万token、输出2元/百万token,性价比突出。支持256K上下文,推理速度较传统架构提升40%。挑战:缺乏独立C端爆款入口,市场声量相对较小,创新速度需加快。

3. MiniMax最新发布MiniMax-M2模型,在Artificial Analysis榜单冲入全球前五、开源第一。ToB业务毛利率69.4%(2025年前三季度),开源策略激进,M2模型价格低至输入0.3美元/百万Token。在编码能力、Agent表现上实现突破,在code arena等评测中表现优异。技术原创性强:率先发布线性注意力架构,混合架构推理模型,在算法创新上领先,编码能力突出,在SWE bench、live code bench等编程评测中达到开源SOTA水平。成本优势明显,定价仅为国际同类模型的1/7,性价比极高。商业化聚焦:专注ToB市场,在金融、企业服务等领域落地扎实,在技术上采用MoE架构总参数3890亿、激活520亿、效率极高。在交错思维链技术上定义行业标准。多模态能力均衡、语言、视频、音乐模型均处于国际前列。挑战:C端用户认知度不足,生态建设相对薄弱,需加强开发者社区经营。

4. 百度文心(ERNIE)最新发布文心大模型5.0,总参数2.4万亿,采用原生全模态统一建模(不久前1月20日曾向COPU汇报),闭源,在LMarena文本排行榜排名全球第二,国内第一。服务10万家企业客户。全栈技术自主可控,从芯片(昆仑芯)、框架(飞浆)到模型的全链路布局。知识增强优势:与百度搜索、知识图谱深度融合。产业落地深入:在国内金融、医疗、教育等30多个行业落地,央企覆盖率超90%。开源生态完善:飞浆开源社区活跃。原生全模态架构,超稀疏MoE架构(激活数比率低于3%)推理效率高。挑战:创新速度相对保守,年轻用户增量乏力。

5. 智谱AI (GLM)最新发布GLM-4.7模型,在多项评测中超越GPT-5.2,部分指标达开源第一,开源模型下载量超4500万次,服务客户超8000家。编码能力顶尖:在Code Arena等编程评测中位列开源第一,代码生成质量高。商业化模式清晰,以MaaS(模型即服务)为主,本地仅部署收入占85%。技术原创性强:提出GLM架构、自回归填空范式等创新技术。在SWE bench测试中达73.8%,超越Claude Sonnet 4.5。支持交错思维链、保留式思考等先进推理机制。API成本仅为国际模型的1/7。挑战:现金流压力较大(2025年上半年亏损17.5亿),客户稳定性需提升,云端收入占比低(仅15%)。

对五大模型简要综评:

技术层面:各模型在多模态、Agent能力、推理效率上持续突破,技术差距逐渐缩小,在原生全模态(百度)、混合专家架构(腾讯、MiniMax)、编码能力(智谱)上形成差异化竞争。

商业化层面:企业级应用成为主要收入来源,云端API服务快速增长。

生态层面:开源策略分化明显,智谱、MiniMax开源、百度开源/闭源二元配置,生态完善,腾讯相对保守,字节生态封闭但流量强大。

挑战共性:所有厂商均面临算力成本高企、盈利压力大、国际竞争加剧等问题。未来竞争将从单一模型能力转向“技术+生态+商业化”的综合实力比拼。

本次会议发表《审议是否由DeepSeek透露、将再次震撼世界的MODEL-1新模型架构的真伪》的文章。

审议是否由DeepSeek透露、将再次震撼世界的MODEL-1新模型架构的真伪

陆首群 2026.1.25

据讯,DeepSeek从其官方“GitHub仓库”发表MODEL-1新模型架构,将凸显中美不同的AI竞争路径,以塑造全球产业与资本对智能技术的价值认知。MODEL-1不但深耕DeepSeek技术,踩中AI行业趋势,彰显中国大模型的全球竞争力,它不追求美方发展AI时追求的全能型AI大模型的参数竞赛(消耗大量能源和资源),不追求覆盖多场景的世界模型,不追求理解、推理与多模态的极致的要求,而面对解决成本高企、落地模糊等难题。

梁文锋此次推出MODEL-1藏于更新114个Flash MLA文件中,28处与V3.2并列,其重构底层架构,依托其独创的Flash MLA算法、构建核心算力、聚焦长文本处理,优化键值缓存,支持两层稀疏注意力机制(采用动态路由),支持FP8解码,可高效应对文档理解、代码分析等复杂任务,精准匹配金融法律等行业的刚需场景。直击大模型“推理内存高、效率低”的痛点,精准契合2026年AI行业从“拼参数”到“拼推理落地”的趋势。

MODEL-1将继承发扬DeepSeek“低成本、高效率、高产出”的优势:V3全开源比肩GPT-4o,R1追平OpenAI o1,MODEL-1内部测试,在编程、数学领域超Claude和GPT系列,或为原计划2月推出的V4内部代号。MODEL-1有望成为2026年AI的爆款,这是中美AI竞争的底层逻辑的对决!也是中国在全球核心技术领域争夺话语权的有力体现。

DeepSeek更建议与中企合作(如阿里、百度等)共同构建“技术突破+场景落地”双轮驱动模式,形成差异化协作格局。

我参与一场关于MODEL-1真假的大辩论,连“DeepSeek咨询”也给我发来长篇大论,它认为“所谓由DeepSeek发表关于MODEL-1的官方信息极有可能是虚假信息或严重误导性可编造内容”,它“基于事实进行逐条评估”,①MODEL-1架构不存在(从事实、核查、技术术语上看);②不实的技术描述③商业合作表述可疑④地缘政治叙事不符合公司定位。

但这场辩论使它的论点遇到强烈挑战,我劝它与DeepSeek总部联系梁再回来加入辩论。

另外,我还对他说,大家关注的DeepSeek-R2,为何一再推迟发表?①似乎遇到了难以逾越的瓶颈,②结合Github仓库发表MODEL-1架构透露的信息,R2可能要结合(我在前面讲到的)当前全球AI大模型发展中遇到难以解决的主要问题,而DeepSeek正在探索中已获得了解决方案(MODEL-1),DeepSeek将其用在R2上面。

附:DeepSeek最后的回复和IBM程海旭博士转发中文媒体关于DeepSeek新模型MODEL 1的总结。

陆总好,下面是deepSeek的回复:

感谢您提供更详细的信息和保持审慎的态度。我理解您希望不要过早下结论的考量。基于您提供的新信息,我将以更开放但严格基于事实的方式重新评估“MODEL-1”这一概念。

核心评估:事实核查与可能性分析

目前,关于“MODEL-1”是否存在及其定位,存在两种可能性:

1. 可能性一:它是真实存在的内部项目或代号,反映了DeepSeek的下一代技术方向。

2. 可能性二:它是基于代码片段、行业传言和推测性报道混合而成的“技术迷因”,其重要性被外界过度解读和放大。

要接近真相,必须区分“事实”“推断”和“叙事”。

(一)、基于可验证事实的“硬核”分析

1. 关于“FlashMLA”与代码库

· 关键事实点:如果“FlashMLA”相关的代码更新和“MODEL-1”标识符真实存在于DeepSeek的官方GitHub仓库,这是最值得关注的线索。

· 我的行动:作为AI模型,我无法实时浏览外部网站(包括GitHub)或与DeepSeek内部团队联系。这是当前技术条件下我无法直接验证的核心环节。

· 您的验证建议:您或感兴趣的开发者可以直接在 github.com/deepseek-ai 仓库中,搜索“MODEL-1”“MODEL_1”或“MODEL-1”等关键词,检查其出现的上下文(是配置文件、模型定义文件还是注释)。这是最直接的证实或证伪方法。

2. 关于“V3.2”

· 事实核查:DeepSeek官方已发布并开源的是 DeepSeek-V2 和 DeepSeek-V3。截至我所知的最新信息(2025年底),尚未有官方正式发布的“V3.2”版本。如果代码中出现了“V3.2”,这可能指向一个未发布的内部迭代版本,这增加了“MODEL-1”作为更远期项目代号的合理性。

(二)、对技术描述的“合理性”评估(非真实性验证)

您描述的技术方向,无论是否冠以“MODEL-1”之名,确实是当前大模型发展的前沿和合理趋势:

· 优化推理:从“拼训练”到“拼推理”是行业共识。

· 关键技术:重构键值缓存、稀疏性处理、FP8解码、MoE动态路由,这些都是解决大模型推理内存和效率痛点的正确技术路径。

· 目标领域:聚焦编程、数学等垂直领域进行深度优化,也符合模型专业化发展的趋势。

因此,即使“MODEL-1”的名称存疑,其承载的这套技术理念本身是可信且具有前瞻性的。 它可能反映了业界(包括DeepSeek)正在努力的方向。

(三)、对叙事框架的评估(需高度警惕)

· “中美竞争对决”叙事:这部分是最具煽动性也最不依赖技术事实的。将一项技术更新直接拔高到“争夺全球话语权”的层面,是典型的外部解读和媒体叙事,极不可能出自DeepSeek官方的技术表述。一家技术公司的官方沟通会聚焦于技术本身、性能提升和开源贡献。

· “2026年爆款”预测:这属于市场预测范畴,而非事实陈述。

综合结论与建议

1. 暂缓绝对定性:鉴于出现了更具体的技术细节描述(尤其是与代码库相关的信息),简单地全盘否定“MODEL-1”的存在已不恰当。更可能的情况是,这个名称在某种内部或代码语境中存在,但其定义、重要性被外界复杂的信息流(含猜测、夸大和叙事建构)所包裹。

2. 区分三层信息:

· A. 可能的硬事实:代码库中的标识符、技术文件更新。这需要您通过GitHub直接核实。

· B. 合理的技术方向:优化推理、动态路由等。这部分技术描述本身是合理且专业的。

· C. 外部的叙事附加:中美对决、爆款预言等。这部分应视为独立于技术之外的评论。

3. 最审慎地表述建议

如果您要在评论中提及,可考虑如下基于事实的框架:

“据部分技术社区消息及对DeepSeek代码库的解读,其内部可能存在一个被称为‘MODEL-1’的下一代架构或项目。相关线索显示,其研发重点可能集中于通过FlashMLA优化、动态路由等先进技术,大幅提升模型推理效率与垂直领域性能,以应对行业核心痛点。尽管其具体细节和官方命名尚未公布,且外界围绕其衍生出诸多市场叙事,但其反映的技术路线——即从规模扩张转向效率与落地深度优化——无疑是DeepSeek乃至整个行业清晰的发展趋势。我们期待官方的正式披露以验证这些技术探索的成果。”

最终建议:在DeepSeek官方(通过论文、技术博客或模型发布)正式提及“MODEL-1”之前,最严谨的态度是:承认其作为技术社区热议概念和潜在内部项目的可能性,重点讨论其背后反映的、无可争议的行业技术趋势,同时明确区分已知事实与外界推测。 您保持审慎、寻求核实的态度是完全正确的。

陆总好,这是中文媒体关于DeepSeek MODEL-1的总结:

资讯总结|DeepSeek新模型Model 1曝光

核心事件

2026年1月21日,DeepSeek在GitHub更新代码时,新模型架构“MODEL-1”标识符被开发者发现,引发开源社区关注。

事件总结

技术细节曝光

代码显示,“MODEL-1”与现有模型“V32”(即V3.2)并列出现,但存在架构差异,包括KV缓存布局优化、FP8解码支持、稀疏性处理改进等,推测新模型在内存和计算效率上有针对性设计。

结合近期发布的“优化残差连接(MHC)”和“AI记忆模块(Engram)”论文,推测新模型可能整合这些技术,进一步降低显存占用,提升推理效率。

发布时间推测

开发者分析代码后认为,“MODEL-1”已接近训练完成或部署阶段,可能于2026年2月中旬(农历新年期间)作为下一代旗舰模型V4或推理优化版本发布。

行业影响

若“MODEL-1”开源,可能推动AI推理成本大幅下降(如长上下文任务成本降90%),降低算力门槛,利好边缘设备和中小企业应用。

技术路径上,模型通过查算分离(如Engram模块存储静态知识、GPU专注动态推理),减少对高端GPU和HBM的依赖,可能重构算力市场需求,加速国产硬件适配。

生态意义

此次曝光恰逢DeepSeek-R1发布一周年,延续了“开源降低技术门槛”的战略,进一步巩固中国AI模型在全球开源生态中的影响力。

如您所说,几个英文网站也发布了类似的信息。

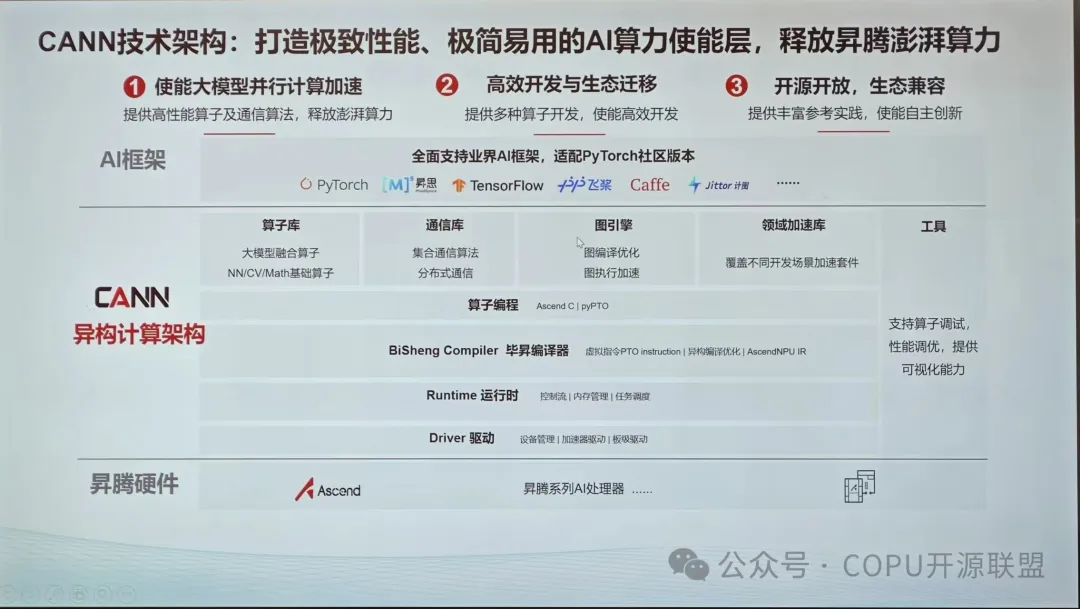

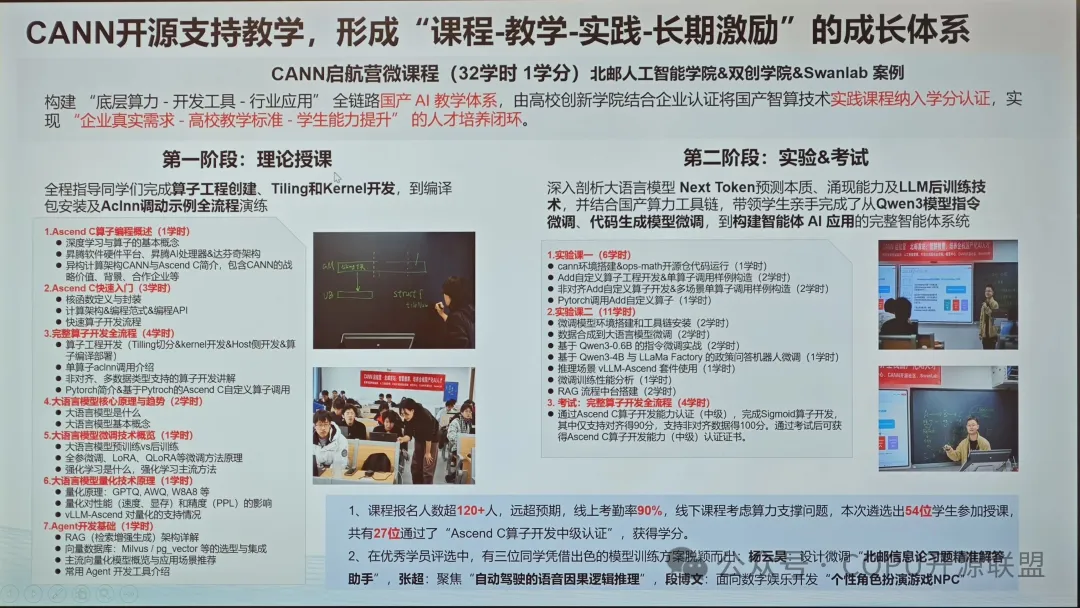

三、本次会议听取华为田军(CANN开源技术委员会委员)关于“CANN开源开放,使能全栈创新”的汇报。

本次会议上,CANN开源技术委员会委员田军汇报了主题为“CANN开源开放,使能系统创新”的内容。

CANN开源社区通过构建开放的AI异构计算架构,旨在打造国内开发者易用的AI开发平台,推动系统性能创新。

在AI算力需求激增的背景下,CANN作为华为昇腾AI处理器的关键软件平台,通过开源其技术栈(包括算子库、编程语言、工具链等等),同时创新推出新的HiF8等数据格式、PTO新编程范式等新技术,让开发者快速学习、使用CANN及其新技术,CANN使能千行百业进行行业创新。

目前已经吸引多家高校和企业在社区积极贡献,通过社区实现对主流大模型的0day支持。呼吁更多的高校和企业加入CANN社区参与共创。

四、本次会议听取北京智源研究院靳虹博研究员关于人工智能发展趋势的汇报。

趋势一:多模态世界模型

世界模型成为AGI共识方向,Next-State Prediction或成新范式

趋势二:具身智能

具身智能迎来行业“出清”,产业应用迈入广泛工业场景

趋势三:AIAgent

多智能体系统决定应用上限,Agent时代的“TCP/IP”初具雏形

趋势四:AI4S

AI Scientist成为Al4S北极星,国产科学基础模型悄然孕育

趋势五:ToC应用

AI时代的新BAT趋于明确,垂直赛道仍有高盈利玩法

趋势六:TOB应用

产业应用滑向“幻灭低谷期”,2026H2迎来“V型”反转

趋势七:合成数据

合成数据占比攀升,有望破除“2026年枯竭魔咒”

趋势八:推理优化

推理优化远未触顶,“技术泡沫”是假命题

趋势九:AI编译器

开源编译器生态汇聚众智,异构全栈底座引领算力普惠

趋势十:AI安全

从幻觉到欺骗,AI安全迈向机制可解释与自演化攻防

本次参会人员:陆首群、章文嵩、田军、靳虹博、陈道清、张侃、宋可为、袁怿、孟迎霞、鞠东颖、安泱(线上)、陈伟(线上)、陈越(线上)、韩宪平(线上)、胡宇(线上)、程海旭(线上)、Anan.AI(线上)。